Le Prompt Engineering : Qu’est-ce que c’est ? 15 Techniques pour des Prompts IA Efficaces

Les outils d’intelligence artificielle (IA) devenant de plus en plus courants dans de nombreux secteurs pour compléter les efforts humains, le prompt engineering (ou « ingénierie de requête ») est apparu comme une compétence essentielle.

Les prompts engineers sont des experts en langage naturel chargés de communiquer avec les grands modèles de langage (LLM) afin d’obtenir les résultats souhaités.

Dans cet article, nous vous expliquons l’essentiel du prompt engineering et ses concepts clés. Nous explorerons également plusieurs techniques permettant de développer des requêtes d’une manière précise et contextuelle.

Pour vous aider à mieux comprendre, nous allons essayer ces prompts avec différents modèles d’IA et voir comment ils réagissent.

Sommaire

Qu’est-ce que le prompt engineering ?

Le prompt engineering consiste à créer des requêtes précises et efficaces afin d’obtenir des résultats d’IA contextuels à partir de grands modèles de langage (LLM). Elle nécessite une expertise en matière de traitement du langage naturel et de capacités LLM.

Les prompt engineers doivent formuler des questions et des énoncés, clairs et spécifiques au contexte, afin d’obtenir les réponses les plus pertinentes et les plus précises de la part du modèle d’IA.

Que ce soit pour générer des rapports marketing détaillés, créer du contenu de site web engageant ou développer le code de langage de programmation parfait, un prompt engineering efficace est une compétence qui permet de gagner du temps et que les professionnels de l’industrie devraient ajouter à leur portefeuille.

Notez qu’un prompt engineer n’a pas besoin d’être familier avec les langages de programmation ou d’avoir des compétences en développement logiciel. Toute personne ayant de bonnes connaissances linguistiques et un esprit analytique peut apprendre le prompt engineering.

Notions de base sur le prompting

Avant de nous plonger dans les techniques de requêtes avancées, examinons les principes de base des prompts pour guider les modèles linguistiques.

Pour commencer, un prompt, une requête ou une invite en français, consiste à utiliser un langage naturel, tel que l’anglais, pour expliquer aux outils d’IA ce que vous voulez et obtenir une réponse pertinente.

Interagir avec les modèles de langage en utilisant des prompts

Les grands modèles de langage sont des outils d’IA génératifs qui créent des textes de type humain en fonction des données qu’ils reçoivent. Ces données sont appelées invites, requêtes, ou prompts.

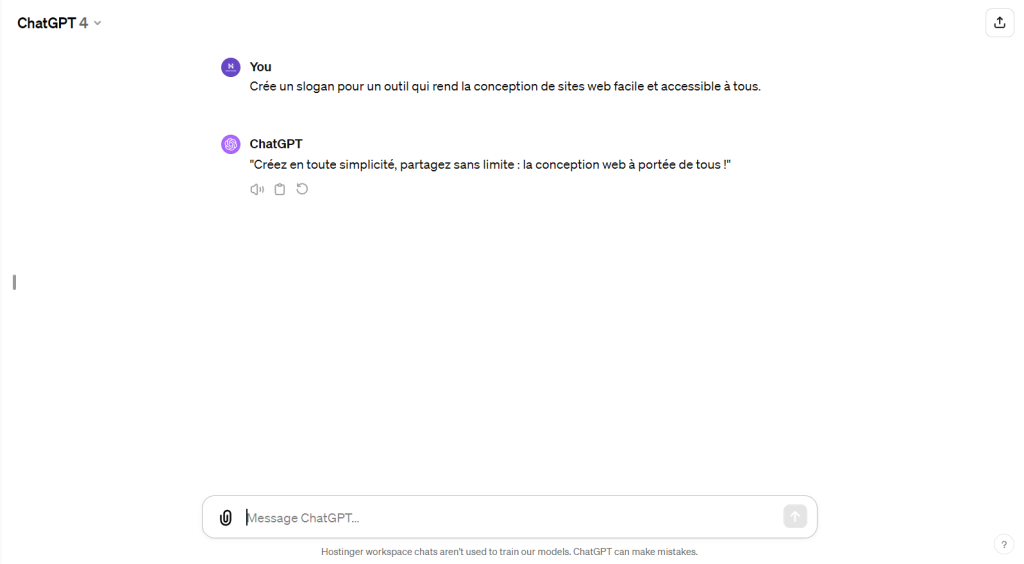

Prenons l’exemple d’une agence web qui souhaite générer un slogan pour un nouvel outil de conception de site web qu’elle a développé. Dans ce cas, un prompt engineering bien conçu pourrait ressembler à ce qui suit :

« Crée un slogan pour un outil qui rend la conception de sites web facile et accessible à tous. »

Cette invite est claire et indique au LLM le type de contenu spécifique requis – un slogan accrocheur et concis ciblant les utilisateurs potentiels d’un outil de conception de site web. L’objectif est de communiquer clairement vos objectifs au LLM afin d’obtenir un résultat précis et pertinent.

Voyons le résultat de ce prompt lorsque nous l’envoyons à ChatGPT-4 :

Le pouvoir du contexte et des instructions

Pour optimiser l’efficacité d’un modèle linguistique, vous devez inclure deux éléments dans vos invites : le contexte et les instructions.

L’ajout du contexte aide le modèle à mieux comprendre le scénario, tandis que l’instruction lui indique ce que vous attendez de lui.

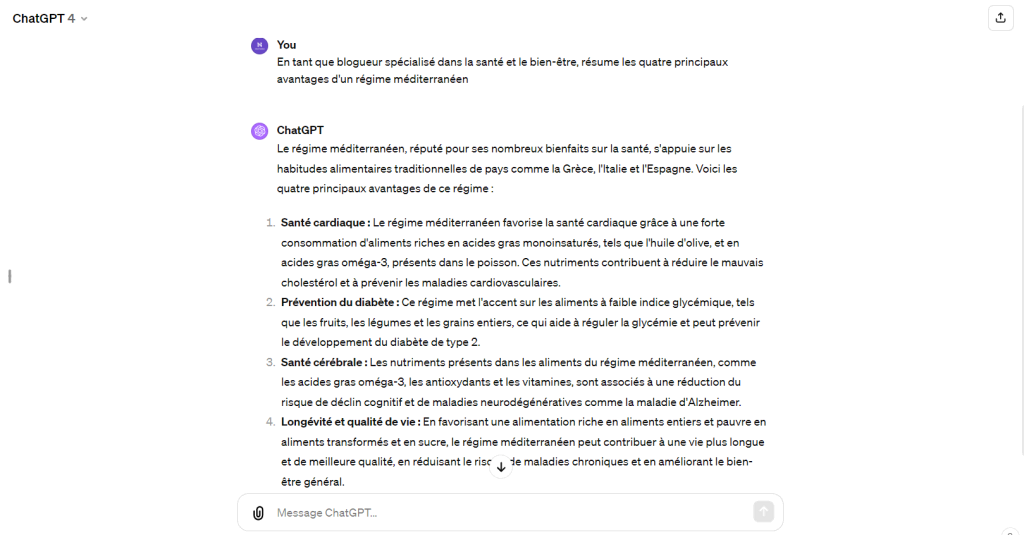

Prenons l’exemple du prompt suivant : « En tant que blogueur spécialisé dans la santé et le bien-être, résume les quatre principaux avantages d’un régime méditerranéen ». Dans ce cas :

- Contexte – « En tant que blogueur spécialisé dans la santé et le bien-être » aide le modèle à comprendre la perspective et la profondeur à partir desquelles il doit aborder le résumé.

- Instructions – « Résume les quatre principaux avantages d’un régime méditerranéen » indique au modèle ce sur quoi il doit se concentrer et ce qu’il doit produire comme résultat.

Il est essentiel de fournir le contexte et des instructions claires pour plusieurs raisons :

- Moins d’ambiguïté – cela réduit le risque de recevoir des résultats non pertinents ou hors sujet.

- Plus de contrôle – obtenez des réponses prévisibles de la part de l’IA

- Gain de temps – moins de communication en amont et en aval pour atteindre le résultat souhaité.

Voici le résultat d’une invite contextuelle lorsque nous l’envoyons à ChatGPT-4 :

Éléments des prompts

Lors de l’élaboration de prompt en langage naturel pour les chatbots d’IA, il est essentiel de comprendre les éléments fondamentaux pour obtenir le résultat souhaité.

Les éléments de l’invite guident le modèle d’IA dans la direction que vous souhaitez, en garantissant la clarté et le contexte.

Voici quelques éléments essentiels à prendre en compte :

La mise en contexte

Une mise en contexte correcte peut faire toute la différence pour obtenir le résultat souhaité.

L’importance du contexte

Le contexte donne à l’IA un arrière-plan clair ou des informations environnantes qui lui permettent de générer un contenu pertinent et approprié. Sans contexte approprié, les réponses risquent d’être génériques ou hors cible.

Par exemple, si vous interrogez le modèle sur les « technologies vertes », l’introduction du contexte « utilisées dans les transports » limite la réponse aux technologies vertes liées aux véhicules.

Introduction du contexte

Un bon prompt ne se contente pas d’avoir un contexte, mais l’introduit de manière efficace. Plus le contexte est détaillé et spécifique, meilleure sera la compréhension de l’IA.

Par exemple, au lieu de « Recommandations pour le commerce électronique », indiquez « Recommandations pour améliorer l’expérience utilisateur d’un site de commerce électronique ».

Des instructions claires

Des instructions claires favorisent les interactions contextuelles de l’IA.

Rédigez des instructions précises

Le fait d’être explicite et direct dans vos instructions garantit une plus grande précision dans les résultats de l’IA et laisse moins de place à l’ambiguïté.

Par exemple, au lieu de demander « Parle-moi des développeurs de sites web », spécifiez « Explique les rôles et les responsabilités d’un développeur de sites web ».

Évitez les formulations vagues

Les formulations ambiguës ou contradictoires peuvent perturber le modèle et conduire à des réponses moins précises.

Par exemple, « Parle-moi de la conception d’un site web » est vague. En revanche, « Parle-moi des tendances en matière de conception de sites web pour les plateformes de commerce électronique » est plus direct.

Le format de sortie souhaité

La spécification du format de sortie est cruciale lors de l’élaboration des invites. Elle permet aux grands modèles de langage d’améliorer la création de contenu.

Le formatage

Le fait de dicter la structure ou le style de la réponse de l’IA permet d’affiner les sorties en fonction de la forme souhaitée.

Par exemple, si vous demandez « Liste les cinq principaux outils pour les développeurs de sites web », vous obtiendrez une liste concise.

Le ton et la longueur

La définition du ton permet d’insuffler une émotion dans les réponses de l’IA. Par ailleurs, la définition de la longueur permet aux modèles d’IA de déterminer la profondeur de leur réponse.

Définissez le ton

Vous pouvez déterminer la résonance émotionnelle ou la qualité professionnelle d’une réponse en indiquant le ton souhaité.

Par exemple, « Fais une critique professionnelle de la conception du site web suivant ».

La longueur détermine la profondeur

Vous pouvez vous assurer que les réponses de l’IA soient adaptées en indiquant s’il s’agit d’un résumé concis ou d’une explication détaillée.

Par exemple, « Rédige une courte introduction (30-40 mots) sur l’évolution de la conception de sites web réactifs ».

Techniques de prompt engineering

Approfondissons maintenant certaines techniques et stratégies fondamentales en matière de prompt engineering pour vous aider à maîtriser les modèles de prompting.

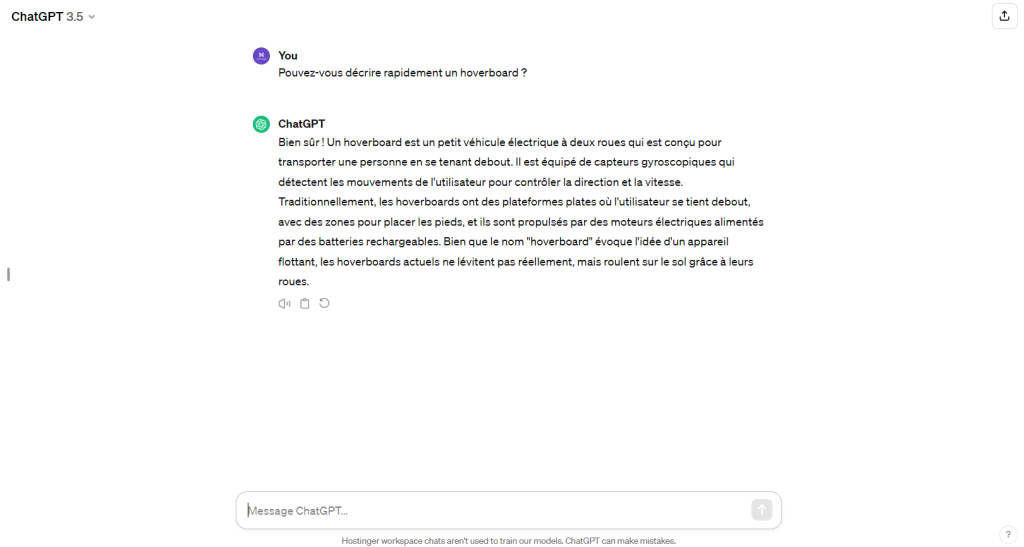

1. Zero-Shot Prompting

La technique du « zero-shot prompting » consiste à générer une réponse sans fournir d’exemples ou de contexte préalable aux grands modèles de langage. Cette technique est idéale lorsque vous avez besoin de réponses rapides à des questions de base ou à des sujets généraux.

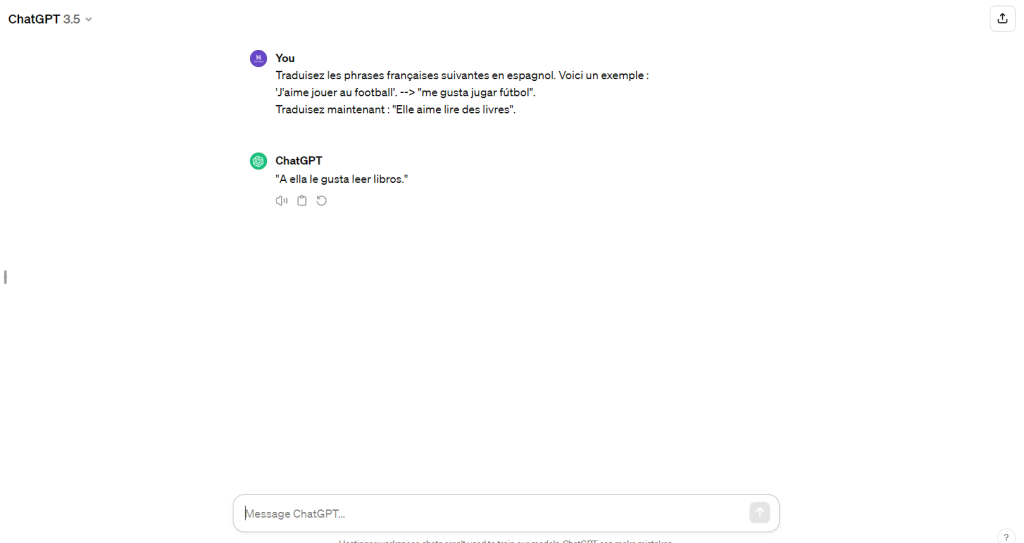

Voici un exemple de zéro-shot prompting avec ChatGPT-3.5 :

2. One-Shot Prompting

Le « One-shot prompting » consiste à extraire une réponse sur la base d’un exemple ou d’un élément de contexte fourni par l’utilisateur.

Pour illustrer notre propos, nous avons essayé cette stratégie avec ChatGPT-3.5 :

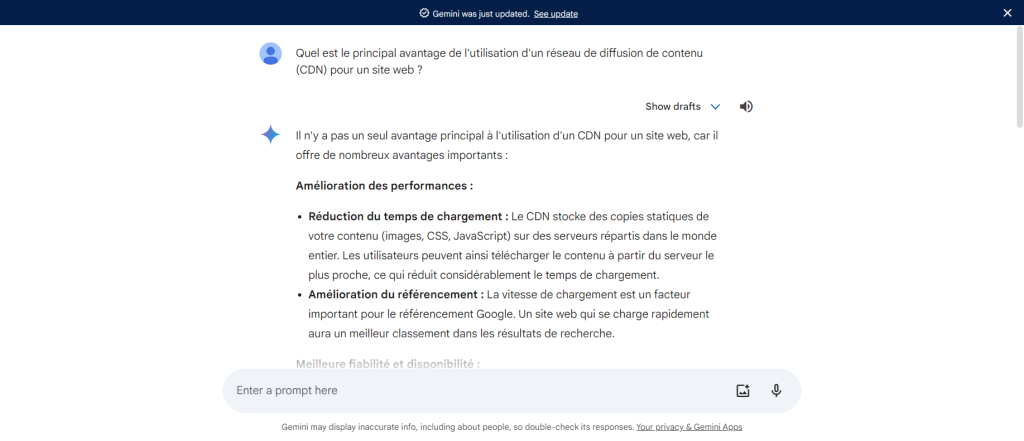

3. Recherche d’informations

Le prompting de recherche d’informations consiste à traiter les grands modèles de langage comme des moteurs de recherche. Il s’agit de poser à l’IA générative une question très spécifique pour obtenir des réponses plus détaillées.

Certains LLM sont plus performants en matière de recherche d’informations grâce à leurs sources de données. Par exemple, Gemini de Google peut accéder aux informations actuelles sur Internet, tandis que ChatGPT ne connaît que ce qui s’est passé avant janvier 2022.

Voici un exemple de prompting de recherche d’informations avec Gemini :

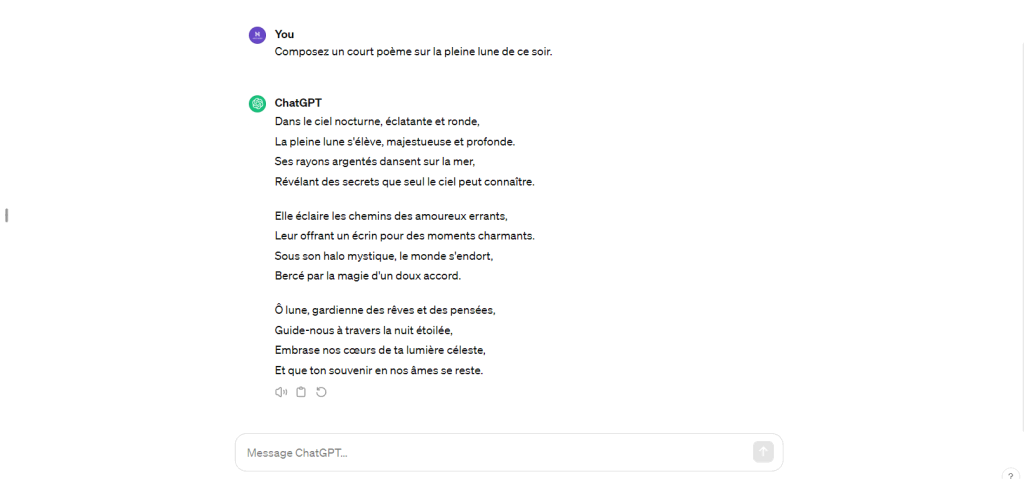

4. Écriture créative

L’élaboration de prompts de contenu créatif peut vous aider à générer des récits imaginatifs, des histoires captivantes et des expressions textuelles uniques adaptées aux préférences et aux intérêts de votre public.

Voici un exemple d’invite qui demande à l’IA générative GPT-3.5 d’écrire de manière créative :

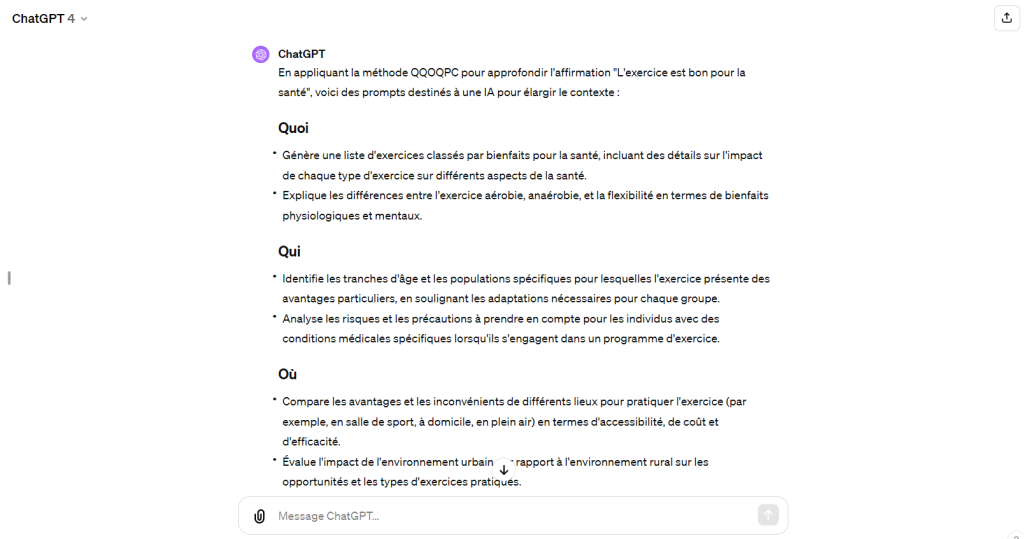

5. Expansion du contexte

La technique d’expansion du contexte consiste à enrichir les informations données à l’IA afin d’améliorer sa compréhension.

Une bonne façon de rédiger des invites d’expansion du contexte est d’utiliser la méthode QQOQPC, qui consiste à étendre la requête en posant des questions de type « qui, quoi, où, quand, pourquoi et comment », en rapport avec le sujet traité.

Voici comment ChatGPT-4 a utilisé cette méthode pour élargir le contexte d’une simple déclaration : « L’exercice est bon pour la santé ».

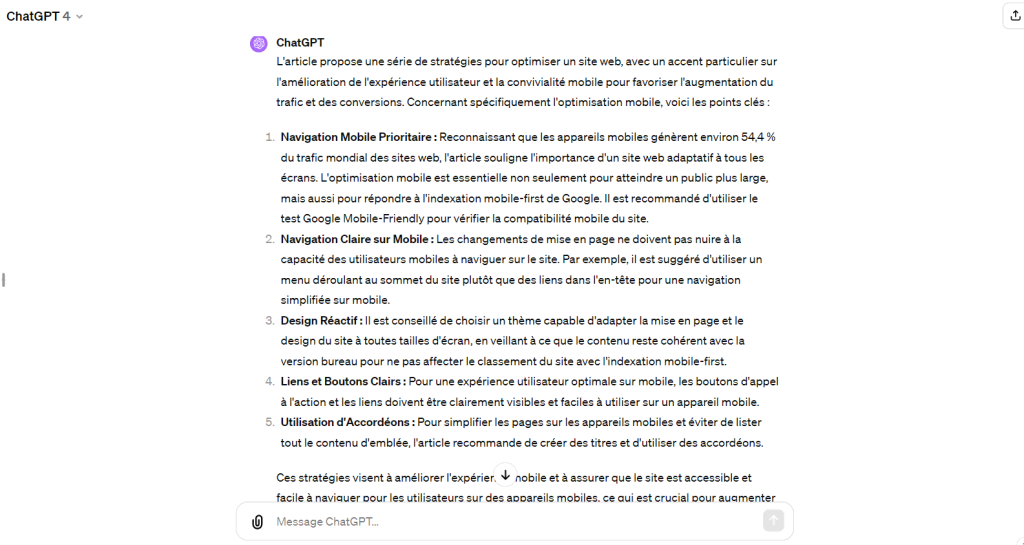

6. Résumé du contenu avec un objectif spécifique

Un prompt engineering efficace consiste également à diriger l’attention de l’IA vers des parties spécifiques de l’entrée, en particulier lorsque vous souhaitez des résumés concis mettant l’accent sur un point particulier.

En élaborant des instructions précises, vous pouvez mettre en évidence les éléments du texte que vous souhaitez que le modèle privilégie, en veillant à ce que le résumé capture l’essence de l’objectif souhaité.

Supposons que vous disposiez d’un guide complet sur les techniques d’optimisation de sites web, mais que vous ne vous intéressiez qu’aux stratégies d’optimisation mobile. Dans ce cas, votre invite doit clairement l’indiquer.

Par exemple, « Résume cet article sur l’optimisation des sites web, mais concentre-toi uniquement sur les stratégies liées à l’optimisation mobile : [copier+coller l’article ici] ».

Voici comment ChatGPT-4 s’est acquitté de cette tâche :

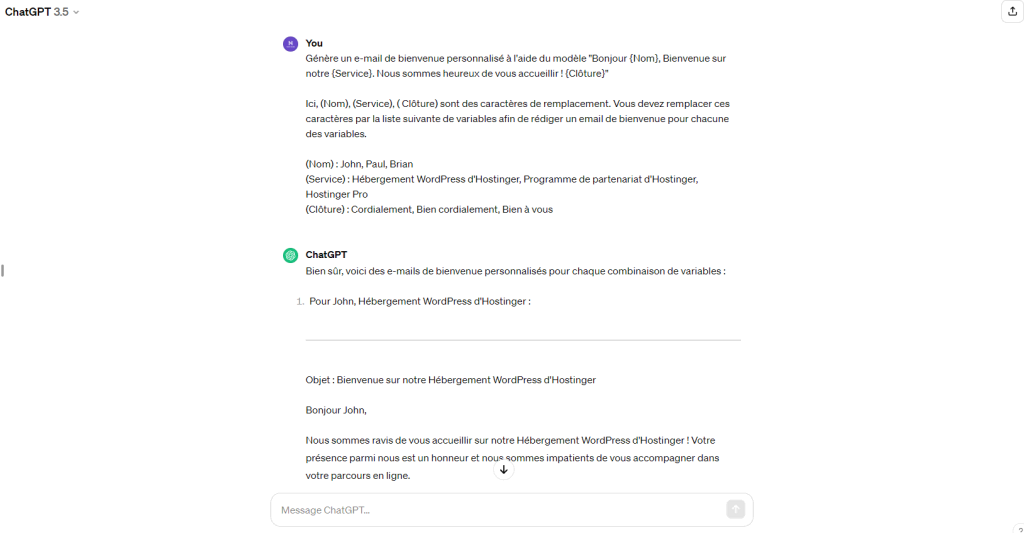

7. Remplissage de templates

Le remplissage de templates vous permet de créer un contenu polyvalent mais structuré sans effort. Vous utiliserez un modèle avec des espaces réservés pour permettre une personnalisation rapide en fonction de différentes situations ou entrées, tout en conservant un format cohérent.

Personnalisation des modèles avec des variables et des placeholders

Dans le remplissage de templates, vous pouvez personnaliser davantage les résultats des outils d’IA générative en définissant plusieurs variables pour les placeholders. En général, les gestionnaires de contenu ou les développeurs web utilisent cette stratégie pour créer plusieurs extraits de contenu personnalisés générés par l’IA pour leurs sites web.

Supposons que vous gériez un site de commerce électronique. Dans ce cas, vous pouvez utiliser un modèle standard pour les descriptions de produits, en permettant à l’IA de remplir des champs tels que le nom du produit, ses caractéristiques et son prix, afin de créer une nouvelle description pour chaque réponse.

Cette technique est extrêmement utile lorsque le contenu généré par l’IA doit respecter des directives ou des formats particuliers.

Un autre cas d’utilisation pratique est la création d’e-mails automatisés mais personnalisés. Le remplissage dynamique des modèles garantit la cohérence de la structure globale de l’e-mail, tandis que le contenu spécifique varie en fonction des informations fournies par l’utilisateur.

Prenons l’exemple suivant : Génère un e-mail de bienvenue personnalisé à l’aide du modèle « Bonjour {Nom}, Bienvenue sur notre {Service}. Nous sommes heureux de vous accueillir ! {Clôture} »

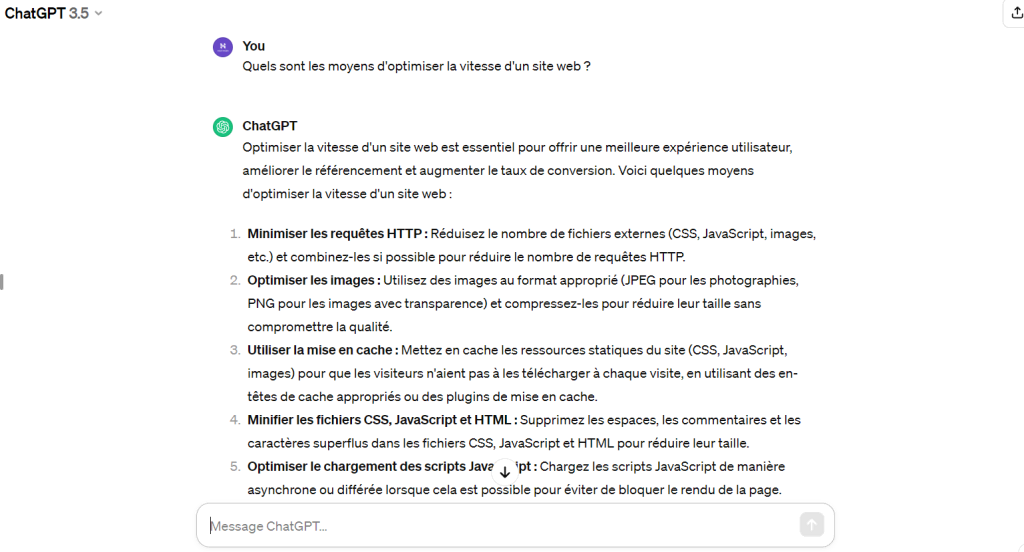

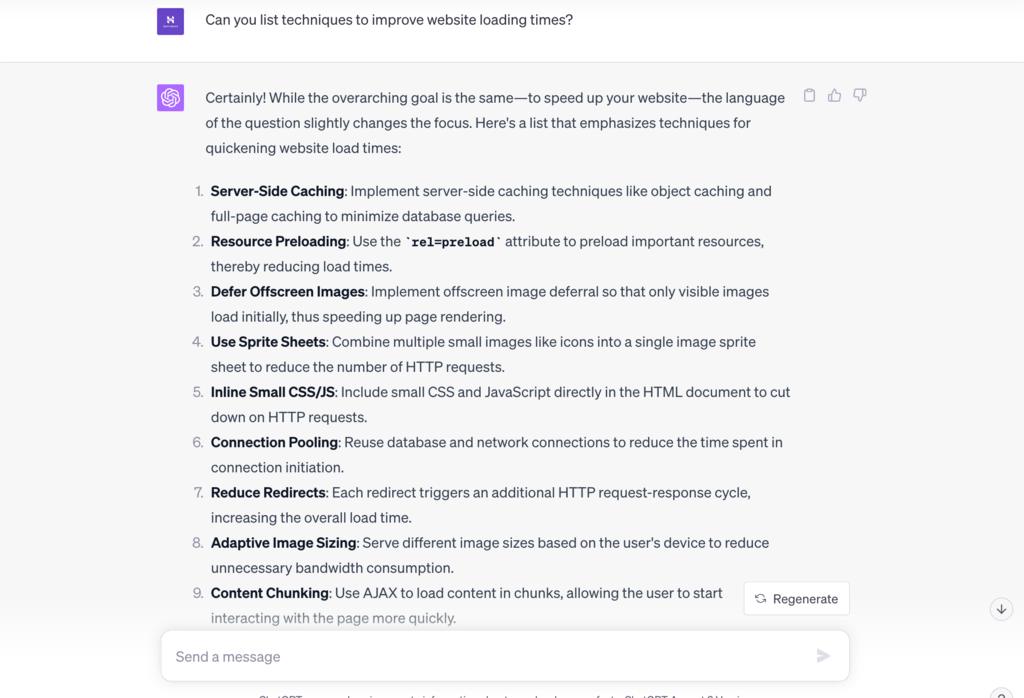

8. Reformulation des prompts

La reformulation des prompts ou la personnalisation des prompts de l’IA vous permet de modifier subtilement la formulation de vos prompts tout en conservant l’intention initiale de la requête.

Cela peut encourager le modèle de langage à produire une variété de réponses qui répondent à l’intention originale de différentes manières.

Les techniques de formulation pour conserver l’intention

Une approche consiste à utiliser des synonymes ou à reformuler les questions tout en conservant le sujet principal. Vous obtiendrez ainsi des réponses plus ou moins nuancées, ce qui peut s’avérer particulièrement utile lorsque vous recherchez des idées différentes.

Exemple

Prompt d’origine – Quels sont les moyens d’optimiser la vitesse d’un site web ?

Prompt reformulé – Peux-tu citer des techniques permettant d’améliorer les temps de chargement d’un site web ?

9. Combinaison de prompts

La technique de combinaison d’invites consiste à fusionner différentes instructions ou questions en une seule invite à multiples facettes afin d’obtenir une réponse complète de la part de l’IA.

Pour ce tutoriel, prenons l’exemple du prompt suivant : « Peux-tu expliquer les différences entre l’hébergement mutualisé et l’hébergement VPS et recommander celui qui convient le mieux à un petit site de commerce électronique ? »

10. Prompt de chaîne de pensées

Un prompt de chaîne de pensées consiste à utiliser les interactions de l’IA en temps réel pour guider l’outil vers des réponses plus précises et plus complètes.

Au lieu de vous fier à une seule invite, vous pouvez fournir une séquence d’exemples ou de questions connexes pour affiner la requête initiale.

Comment utiliser les invites de chaîne de pensées ?

La clé d’un prompt de chaîne de pensée efficace consiste à décomposer une question ou un sujet complexe en parties plus petites et plus faciles à gérer. Présentez ensuite ces parties sous la forme d’une séquence d’invites qui se renforcent les unes les autres, en poussant l’IA vers la réponse souhaitée.

Nous avons demandé à ChatGPT-4 de nous fournir un exemple de prompt de chaîne de pensée, et voici ce qu’il nous a proposé :

11. Prompting itératif

Le prompting itératif est une autre technique efficace qui vous permet de vous appuyer sur les réponses précédentes en posant des questions de suivi. Elle vous permet d’approfondir un sujet, d’extraire des informations supplémentaires ou de clarifier les ambiguïtés de la réponse initiale.

Comment utiliser le prompting itératif ?

La clé est d’être attentif à la réponse initiale de l’IA. Vous pouvez formuler votre demande de suivi de manière à développer une partie spécifique de cette réponse, à approfondir un sous-sujet ou à demander des éclaircissements. Cette méthode est particulièrement utile lorsque vous avez besoin de recueillir des informations détaillées.

Les LLM qui maîtrisent mieux le traitement du langage naturel (NLP) peuvent traiter de manière experte les prompts itératifs et rédiger leurs réponses à la manière d’un humain.

Voici un exemple rapide d’iterative prompting avec Claude AI, un LLM doté de bonnes capacités de traitement du langage naturel :

12. Narration interactive et jeu de rôle

La narration interactive et les jeux de rôle avec l’IA constituent un moyen créatif et attrayant de produire un contenu dynamique.

Cette technique tire parti de la capacité de l’IA à adapter ses réponses en fonction des instructions et des interactions précédentes, ce qui permet une narration fluide et évolutive.

La narration collaborative

La narration collaborative va plus loin en permettant à l’IA de s’adapter à vos données en temps réel. Elle permet un échange dans les deux sens où l’outil et vous-même contribuez au déroulement de l’histoire, créant ainsi une expérience interactive et immersive.

Exemple

Prompt – J’aimerais commencer un exercice de narration en collaboration avec toi. Nous allons écrire une histoire fantastique sur un pays où la magie existe mais a été oubliée depuis longtemps.

Voici le personnage principal et l’objectif final de l’histoire :

Le personnage : Doraleous, un jeune fermier qui découvre par hasard un ancien livre de sorts.

L’objectif : Exploiter le pouvoir de la magie pour mettre fin à la famine qui frappe leur hameau forestier.

13. Injection implicite d’informations

Avec l’injection implicite d’informations, vous infusez subtilement du contexte pour que le modèle d’IA comprenne vos besoins sans avoir à les expliquer de manière explicite.

Stratégies pour le contexte implicite

Cette technique peut s’avérer particulièrement utile lorsque vous souhaitez obtenir des réponses nuancées ou personnalisées. Par exemple, au lieu de dire « Rédige ceci sur un ton formel », vous pouvez utiliser des mots comme « élaboré » ou « détaillé » pour guider l’IA vers un résultat plus formel.

Exemple

Prompt – Peux-tu me donner quelques conseils rapides pour augmenter le trafic d’un site web ?

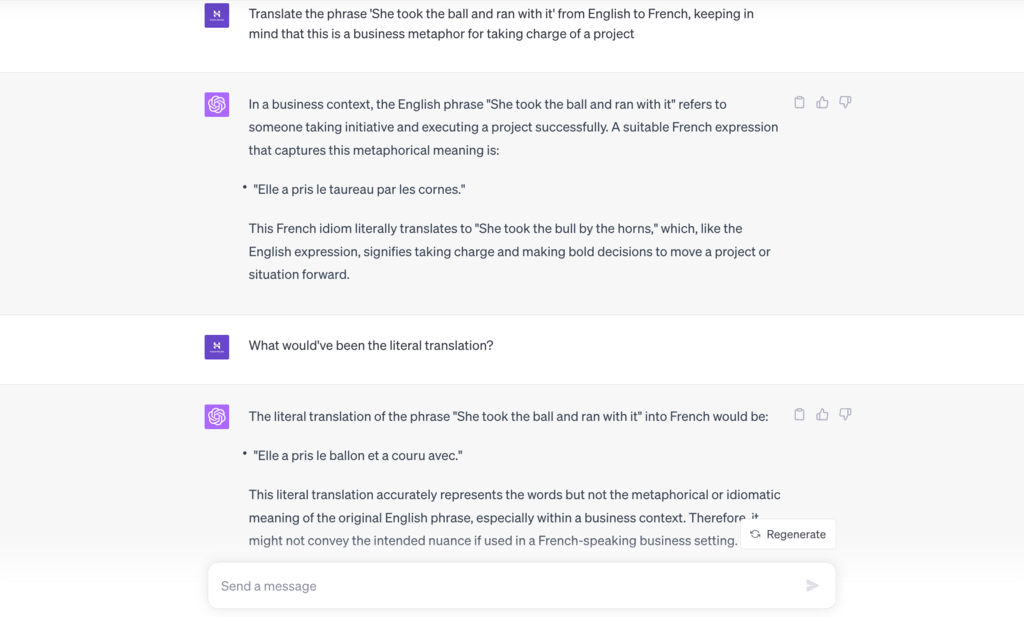

14. Traduction linguistique avec une nuance contextuelle

La génération de contenu multilingue ne se limite pas à la conversion de mots d’une langue à l’autre. En utilisant le prompt engineering, vous pouvez vous assurer que l’IA prend en compte le contexte culturel ou situationnel, ce qui permet d’obtenir une traduction plus précise et plus nuancée.

Améliorer la précision des traductions grâce au contexte

En ajoutant des indices culturels ou situationnels dans l’invite, vous pouvez guider l’IA pour qu’elle fournisse une traduction adaptée au contexte. C’est particulièrement utile dans les communications d’entreprise, les documents juridiques ou tout autre texte où une nuance peut radicalement changer le sens.

Exemple

Prompt – Traduis l’expression « She took the ball and run with it » de l’anglais au français, en gardant à l’esprit qu’il s’agit d’une métaphore commerciale pour désigner la prise en charge d’un projet.

15. Prompt Engineering automatique

L’Automatic Prompt Engineering (APE) est une avancée dans le domaine de l’ intelligence artificielle qui exploite les nouvelles capacités des LLM pour aider l’IA à générer et à sélectionner automatiquement des instructions pour elle-même.

Il transforme la tâche en un problème d’optimisation en boîte noire, en utilisant des algorithmes d’ apprentissage automatique pour générer et évaluer les solutions potentielles de manière heuristique.

Un agent IA utilise une méthode similaire pour décomposer les tâches et générer automatiquement des invites de suivi, réalisant ainsi des travaux donnés avec un minimum d’interaction humaine.

Le flux de travail d’APE expliqué

Le flux de travail d’APE se compose de cinq étapes principales :

- Vous donnez au chatbot une tâche spécifique à effectuer et lui montrez quelques exemples.

- Le chatbot propose différentes façons d’effectuer le travail, soit par un raisonnement simple, soit en considérant des tâches similaires qu’il connaît.

- Ces différentes méthodes sont ensuite testées dans la pratique.

- Le chatbot évalue l’efficacité de chaque méthode.

- L’IA choisit alors la meilleure méthode et l’applique.

Avantages et applications en matière d’apprentissage automatique

Lorsqu’ils sont dotés de capacités d’auto-prompts, les outils d’IA générative peuvent rationaliser des tâches allant de l’analyse de données contextuelles au service client automatisé, en éliminant la nécessité de recourir constamment à des prompts générés par l’homme.

Nous avons demandé à ChatGPT-4 d’expliquer le flux de travail de l’APE à l’aide d’un exemple simple :

Cas d’utilisation du prompt engineering

Voyons comment vous pouvez utiliser ces techniques dans divers scénarios pratiques allant du développement de code et de la génération de contenu optimisé pour le référencement au diagnostic médical.

Génération et débogage de code

Le prompt engineering peut être très utile pour la génération de code et le débogage. Vous pouvez créer des invites spécifiques pour amener l’IA à produire des extraits de code, à déboguer du code existant ou même à suggérer d’autres méthodes de codage.

Par exemple, vous pouvez utiliser une invite telle que « Génère une fonction Python pour calculer la factorielle d’un nombre » pour obtenir un code fonctionnel.

Produire des articles adaptés au référencement (SEO)

En plus de demander à l’IA de créer un article à partir de zéro, vous pouvez l’utiliser pour améliorer vos articles actuels. L’une des pratiques les plus courantes d’optimisation du contenu par l’IA consiste à copier l’intégralité d’un article de blog et certains mots clés que vous souhaitez que l’outil ajoute naturellement.

Personnalisation des assistants virtuels

Avec les bons prompts, vous pouvez personnaliser les assistants virtuels pour qu’ils communiquent avec le public ciblé sur votre site web. Ceci est particulièrement important pour les entreprises qui cherchent à offrir une expérience de communication personnalisée à leur public.

En utilisant des techniques de prompt engineering, vous pouvez créer des interactions qui sont non seulement fonctionnelles, mais aussi personnalisées en fonction des préférences et de l’historique de chaque utilisateur.

Soutien à l’apprentissage et à l’éducation

Des invites bien conçues peuvent contribuer de manière significative à l’éducation et à l’apprentissage. En utilisant les techniques discutées, vous pouvez devenir votre propre prompt engineer et utiliser des modèles d’IA pour mieux comprendre des théories complexes telles que les dérivés, l’intégration et la grammaire.

Exemple

Prompt – Peux-tu m’expliquer comment conjuguer le verbe « être » au présent, étape par étape ?

Analyse et interprétation des données

Le prompt engineering peut aider à extraire des informations utiles à partir d’ensembles de données complexes. Après leur avoir donné accès à de grandes sources de données, vous pouvez demander aux LLM d’analyser les informations et de générer des résumés visuels grâce à l’IA multimodale.

Vous pouvez créer des invites pour que l’IA recherche des tendances, des modèles et des relations dans les données qui peuvent ne pas être immédiatement apparentes.

Par exemple, en tant que prompt engineer chargé d’analyser et d’interpréter un vaste ensemble de données, vous pouvez inviter un générateur d’images utilisant l’IA à créer des diagrammes ou des graphiques pour mettre en évidence les tendances et les corrélations importantes dans les données.

Vous pouvez ensuite utiliser des prompts itératifs et demander à l’IA d’interpréter la visualisation et de fournir des descriptions significatives, les idées et les conclusions que l’on peut en tirer.

En posant des questions ciblées par le biais d’invites de recherche d’informations, vous pouvez aider l’IA à identifier des résultats significatifs et à formuler la conclusion qui se dégage des données.

Vous pouvez ensuite utiliser la synthèse de contenu pour distiller des informations complexes en éléments clés à retenir.

Recherche et diagnostic médical

Le prompt engineering peut changer la donne dans le domaine de la recherche et du diagnostic médical. Grâce à des invites et des APE méticuleusement conçus, les applications d’IA peuvent aider les diagnosticiens à analyser les symptômes, à parcourir la littérature médicale et même à proposer des traitements potentiels.

Par exemple, un prompt pourrait guider l’IA dans l’analyse de nombreux documents de recherche afin d’identifier les traitements possibles d’une maladie rare.

Toutefois, le fait de discuter de vos symptômes avec l’IA n’est pas une alternative à la consultation d’un médecin. N’oubliez pas que l’IA n’est qu’un outil auquel on ne peut pas faire entièrement confiance.

Conseils pour un prompt engineering efficace

Pour que le prompt engineering soit efficace, il faut comprendre les techniques et bien les appliquer. Voici quelques conseils pour affiner votre approche.

Analysez les réponses du modèle

Il est important d’étudier la façon dont le modèle réagit aux différentes requêtes. Cette compréhension vous aidera à améliorer vos prompts pour obtenir des réponses plus précises et plus complètes, en particulier lorsque vous travaillez avec des outils d’IA générative.

Tirez parti du feedback des utilisateurs

Un moyen très efficace d’améliorer le prompt engineering consiste à donner activement aux applications d’IA un feedback sur la façon dont elles répondent à votre requête.

L’intégration du feedback est l’une des capacités les plus importantes des LLM, car elle aide les outils d’IA générative à affiner les modèles de langage. Elle leur permet essentiellement d’être mieux équipés pour vous donner exactement ce que vous voulez.

Adaptez-vous aux mises à jour du modèle

Il est essentiel de se tenir au courant des modifications de l’architecture du modèle, des données ajoutées et des nouvelles capacités des LLM. Cela vous permettra d’ajuster vos prompts et de mieux exploiter les nouvelles fonctionnalités.

Collaboration et contribution de la communauté

Le fait de travailler avec d’autres personnes offre de nouvelles perspectives en matière de prompt engineering. Vous pouvez demander l’avis de la communauté sur les forums, les médias sociaux et les réseaux professionnels afin d’améliorer vos compétences en matière d’élaboration d’invites.

Expérimentez différentes stratégies d’invite

En essayant différentes techniques, vous comprendrez mieux ce qui fonctionne le mieux. Vous serez ainsi plus flexible dans l’application des prompts à différents cas d’utilisation et contextes.

Tendances futures en matière de Prompt Engineering

Intégration à la réalité augmentée (RA) et à la réalité virtuelle (RV)

Le prompt engineering peut améliorer les expériences immersives AR/VR en optimisant les interactions pilotées par l’IA dans les environnements 3D. Les avancées en matière de prompt engineering peuvent permettre aux utilisateurs de converser avec des personnages d’IA, de demander des informations et d’émettre des commandes en utilisant le langage naturel dans des contextes simulés en temps réel.

Les ingénieurs en prompt engineering peuvent donner à l’IA un contexte spatial, situationnel et conversationnel qui lui permet de nourrir des échanges remarquablement humains dans les jeux, les formations, le tourisme et d’autres applications AR/VR.

Les requêtes peuvent également tenir compte de la position, des actions et de l’environnement de l’utilisateur pour permettre des réponses très pertinentes.

Créativité interdomaines

En repoussant les limites du prompt engineering, l’IA peut être inspirée pour générer des œuvres d’art, de la musique, des histoires et d’autres œuvres créatives inédites. Les prompt engineers peuvent guider l’IA pour qu’elle mélange des concepts sur différents supports et dans différents genres, ou pour qu’elle combine la créativité humaine et celle de la machine dans des œuvres collaboratives.

Le prompt engineering peut continuellement explorer de nouvelles applications de la créativité de l’IA tout en répondant aux préoccupations éthiques. S’il est mis en œuvre de manière réfléchie, il pourrait démocratiser l’accès aux outils artistiques de l’IA.

Traduction et communication en temps réel

Le prompt engineering pourrait permettre la traduction instantanée des langues parlées et écrites. Les requêtes pourraient fournir un contexte dans plusieurs langues afin que l’IA puisse traduire dans les deux sens en temps réel tout en conservant les nuances.

Cela pourrait permettre une communication multilingue transparente dans des contextes commerciaux, diplomatiques et personnels. Un prompt engineering minutieux est nécessaire pour tenir compte des dialectes régionaux, des nuances culturelles et des modèles d’élocution.

Conclusion

Le prompt engineering est une discipline émergente de l’informatique qui peut révolutionner la façon dont nous interagissons avec la technologie. La maîtrise de cette compétence est essentielle pour exploiter l’ensemble des fonctionnalités des LLM, de la condensation de données complexes à l’exécution de traductions linguistiques nuancées.

Bien que certains modèles de langage excellent dans certains types d’invites, une requête bien conçue peut considérablement améliorer la qualité des réponses de n’importe quel outil d’IA générative.

Pour devenir compétent en prompt engineering, il est nécessaire d’adopter un état d’esprit itératif. Cela implique des tests continus, la collecte d’informations auprès des utilisateurs, l’exploitation de la sagesse de la communauté et l’adaptation aux nouvelles capacités des LLM.

Le développement efficace de requêtes commence par les techniques de base. Commencez par expérimenter la recherche d’informations, l’amplification du contexte, le résumé, le recadrage et les prompts itératifs pour vous familiariser avec les modèles de langage.

Si vous connaissez d’autres stratégies en matière de prompts, n’hésitez pas à les partager dans les commentaires ci-dessous. Vos contributions enrichiront le savoir collectif des prompt engineers qui liront cet article.

Prompt Engineering – FAQ

Nous allons maintenant répondre aux questions les plus fréquemment posées sur le prompt engineering.

Quels sont les avantages de l’utilisation du Prompt Engineering ?

Le prompt engineering améliore les performances des grands modèles de langage, en les rendant plus efficaces et plus polyvalents pour générer des résultats utiles. Il est essentiel pour des tâches telles que la recherche d’informations, l’analyse de données, l’amélioration du contenu de l’IA et la génération d’un langage personnalisé.

Quelle est la difficulté du Prompt Engineering ?

Le prompt engineering est une compétence relativement facile à apprendre. Toutefois, nous recommandons aux débutants de commencer par des requêtes simples, puis de passer à des concepts plus complexes qui nécessitent une compréhension nuancée du traitement du langage naturel et une modélisation efficace du langage pour élaborer des requêtes de données optimisées.

Pouvez-vous trouver des offres d’emploi dans le domaine du Prompt Engineering ?

Oui, à mesure que l’IA et l’apprentissage automatique se développent, la demande de rôles spécialisés tels que le métier de prompt engineer (ingénieur de requête) augmente. De nombreuses entreprises technologiques et institutions de recherche créent des postes qui impliquent des responsabilités telles que le développement d’invites dans le cadre d’équipes spécialisées dans la science des données.

Quel est le rôle d’un Prompt Engineer ?

Un prompt engineer est spécialisé dans l’élaboration de requêtes ou d’instructions pour guider les grands modèles de langage et les systèmes d’IA. Il se concentre sur l’optimisation des interactions entre l’utilisateur et l’IA, garantissant des résultats plus précis et plus significatifs dans diverses applications, de l’analyse des données à l’engagement des clients.